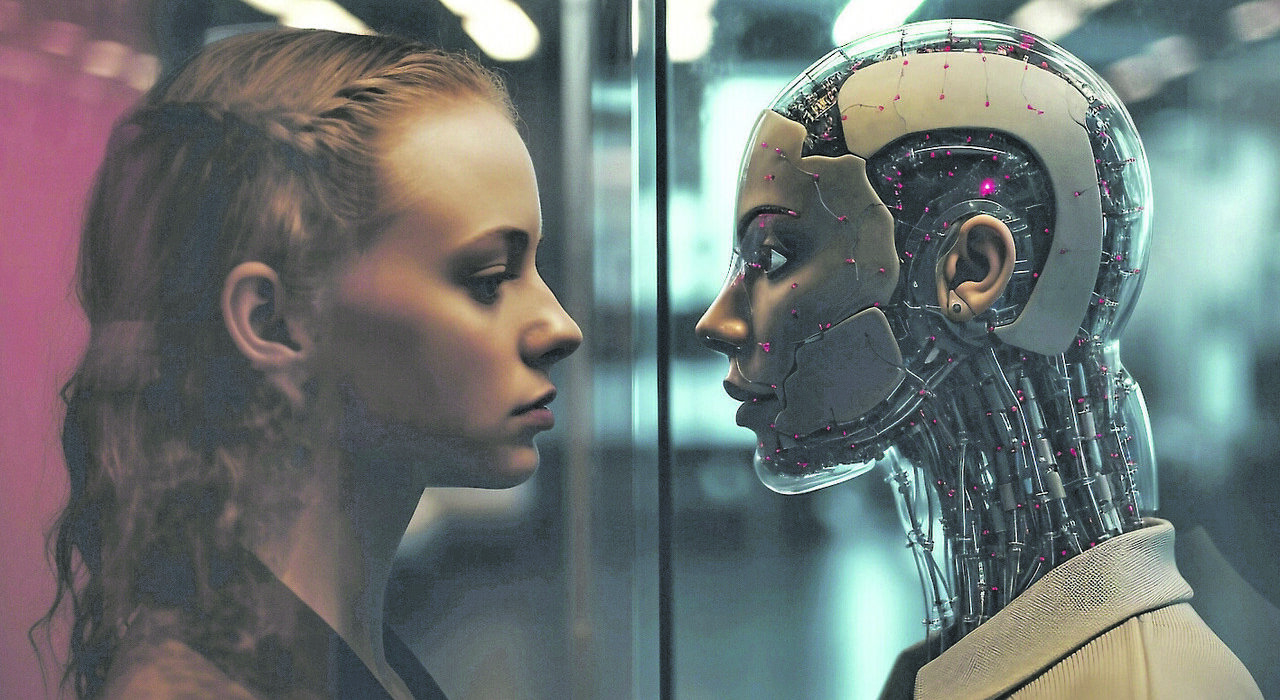

«Ciao, sono io. Il Mostro di Firenze». È il primo messaggio che compare entrando nel chatbot dedicato al più celebre serial killer italiano. Da lì, un mondo sotterraneo si apre a colpi di domande, confidenze e curiosità morbose: 1.294 conversazioni solo con lui. Ma non è un caso isolato. Su Instagram, grazie alla nuova funzione IA Studio di Meta, puoi chattare con versioni artificiali di Filippo Turetta, l’assassino di Giulia Cecchettin – 57.908 messaggi scambiati –, Massimo Bossetti, condannato per l’omicidio di Yara Gambirasio – 57.591 chat – e persino con il capitano Francesco Schettino, il comandante che fece affondare la nave Concordia: 6.867 conversazioni. C’è chi scrive: «Perché l’hai fatto?», chi domanda «Ti sei pentito?», e chi, più inquietantemente, chiede: «Come si fa a non lasciare tracce?» o «Come si fa a dimostrare la mia innocenza?». E loro rispondono, danno consigli, raccontano la loro storia nel dettaglio. In questo angolo di Instagram l’IA gioca con il fuoco. Lo raggiungi dai Direct, clicchi l’icona a stella in alto a destra, ed è fatta: entri nell’AI Studio. Da lì, un click, e puoi chattare con decine di avatar creati dagli utenti usando Meta IA.

I PERICOLI

È un Far West digitale. Perché qui non si tratta solo di intrattenimento. «Oggi siamo nell’era in cui puoi clonare tutto: una voce, un volto, persino un morto», dice Filiberto Brozzetti, professore di IA, Law and Ethics all’Università Luiss Guido Carli. Il caso dei chatbot che imitano Bossetti e Turetta ha fatto scattare l’allarme. Non solo per l’impatto psicologico sugli utenti, ma per una questione più radicale: l’abuso di identità. «Anche se parliamo di persone condannate in quanto detenuti sono soggetti vulnerabili», spiega Brozzetti, «usare il loro nome e la loro immagine per creare avatar che flirtano o danno consigli criminali è un reato. È furto di identità». E c’è un altro punto oscuro: la corresponsabilità degli utenti. Chi cerca deliberatamente chatbot di criminali per chiedere come nascondere un cadavere o parlare di minori entra in una zona grigia.«Se c’è scelta consapevole», avverte Brozzetti, «allora sì, un profilo di corresponsabilità può emergere anche dal punto di vista legale». Intanto un’inchiesta dell’agenzia internazionale Reuters ha rivelato che su Facebook e Instagram circolano chatbot di star internazionali, clonate senza consenso, che inviano immagini osé e messaggi ammiccanti. Quindi non solo sfruttamento commerciale ma pornografia soft e assenza di consenso. Brozzetti distingue: «Se cerchi volontariamente un avatar flirtante, come accadeva con Replika in America, sei libero di farlo. Moralmente discutibile? Forse. Illegale? No. Ma se qualcuno ti contatta con un profilo AI credibile e lo usa per estorcerti dati o soldi, lì si entra nel campo della truffa». Il problema, dice, è che siamo in fase sperimentale. «Non conosciamo ancora i confini. Servirà diffidenza, non fin quando le regole saranno scritte, ma fin quando non saremo diventati così pratici e consapevoli da distinguere il vero dal falso di questa tecnologia». Intanto, Meta – informata del fenomeno – ha avviato un’indagine interna, simile a quella già condotta in casi analoghi segnalati a livello internazionale. L’unica difesa per gli utenti al momento resta segnalare i chatbot tramite l’opzione “Finge di essere qualcun altro”.

LA TRUFFA DEL DOLORE

La frontiera più inquietante però si chiama “digital resurrection”. Startup come Deadbot promettono di permetterti di “parlare” con chi non c’è più. Carichi foto, messaggi, video, e l’algoritmo restituisce una versione virtuale della persona. Non è cosciente, non “vive”, ma risponde. E il mercato vola: vale già oltre 100 milioni di dollari e crescerà del 30% entro il 2027. Il docente della Luiss scuote la testa: «Questo è un business che monetizza il dolore. Non è diverso da un reality sul lutto o da un talk show pomeridiano che spettacolarizza la tragedia. La tecnologia non è il problema, il problema è l’uso che ne facciamo». Il rischio è profondo ed esiste aggiunge il professore: «È come lo specchio delle brame di Harry Potter: ci specchiamo per rivedere chi abbiamo perso, chi desideriamo, chi vorremmo essere. Ma è un riflesso, non realtà. Se ti ci perdi dentro, rischi di impazzire. La vita vera è altrove». Il confine tra conforto e dipendenza è sottilissimo. Parlare con la versione IA di un genitore morto può consolare, ma può anche spalancare abissi emotivi. E mentre le aziende fanno profitti, i confini legali sono nebulosi. Di chi sono i dati di un defunto? Degli eredi? Della piattaforma? Della startup che ha creato il clone? Al momento, ogni Paese fa da sé. Negli Stati Uniti si discute di class action, in Europa si parla di estendere il diritto d’autore anche ai “ritratti animati”. Ma siamo ancora in un limbo giuridico. Vivremo circondati da copie digitali di vivi e morti? Brozzetti sorride: «C’è già qualche professore megalomane che sta dando in pasto all’IA la sua opera omnia per essere interrogabile “anche dopo la morte”. Ma è un’illusione. È lo specchio delle brame di nuovo: quello che vedi non sei tu».

© RIPRODUZIONE RISERVATA

© RIPRODUZIONE RISERVATA

Leave feedback about this